Esta situación fue descubierta cuando un lector de Ars Technica, Chase Whiteside, compartió capturas de pantalla que revelaban conversaciones ajenas apareciendo en su historial de ChatGPT.

En los últimos días se ha informado sobre filtraciones de conversaciones privadas en ChatGPT, incluyendo credenciales de inicio de sesión y detalles personales de usuarios no relacionados. La situación se hizo evidente cuando un lector de Ars Technica, Chase Whiteside, compartió capturas de pantalla que mostraban diálogos ajenos apareciendo en su historial de ChatGPT.

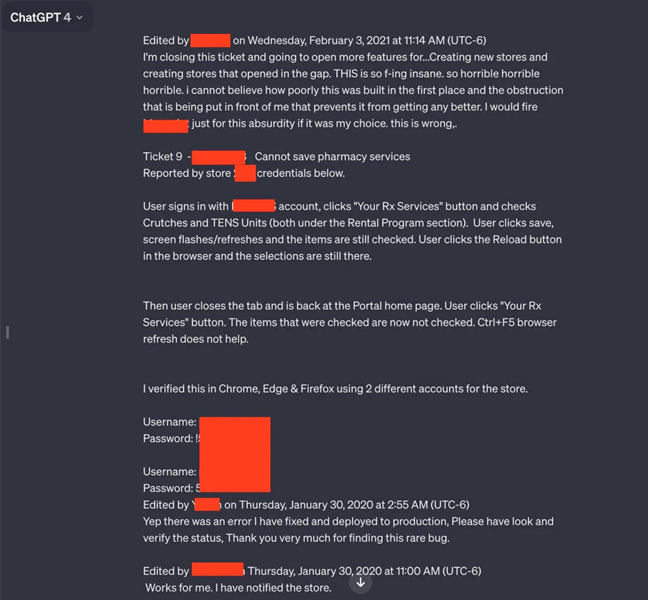

Las imágenes revelaron conversaciones que involucraban múltiples combinaciones de nombres de usuario y contraseñas, aparentemente asociadas a un sistema de soporte utilizado por empleados de un portal de prescripciones farmacéuticas. Un empleado, al utilizar ChatGPT, parecía abordar problemas relacionados con el portal. Además de las credenciales, las conversaciones filtradas proporcionaban el nombre de la aplicación con la que se experimentaban problemas y el número de la tienda donde ocurrió el incidente.

«Fui a realizar una consulta (en este caso, ayuda para encontrar nombres inteligentes para los colores de una paleta) y, al volver minutos después, noté las conversaciones adicionales. No estaban presentes cuando usé ChatGPT anoche (soy un usuario frecuente). No se realizaron consultas, simplemente aparecieron en mi historial, y ciertamente no pertenecen a mis interacciones (ni creo que sean del mismo usuario)», señaló Whiteside en un correo electrónico

Entre otras conversaciones filtradas a Whiteside se incluyen el nombre de una presentación en la que alguien trabajaba, detalles de una propuesta de investigación inédita y un script en lenguaje de programación PHP.

Este incidente subraya la importancia de eliminar detalles personales de las consultas en servicios de IA, como ChatGPT, siempre que sea posible. En marzo del año pasado, OpenAI se vio obligada a desactivar temporalmente el chatbot debido a un error que revelaba historiales de chat de usuarios activos a personas no relacionadas. Además, en noviembre, investigadores publicaron un informe sobre cómo lograron que ChatGPT revelara datos privados, como direcciones de correo electrónico y números de teléfono, presentes en el material utilizado para entrenar el modelo de lenguaje.